摘要

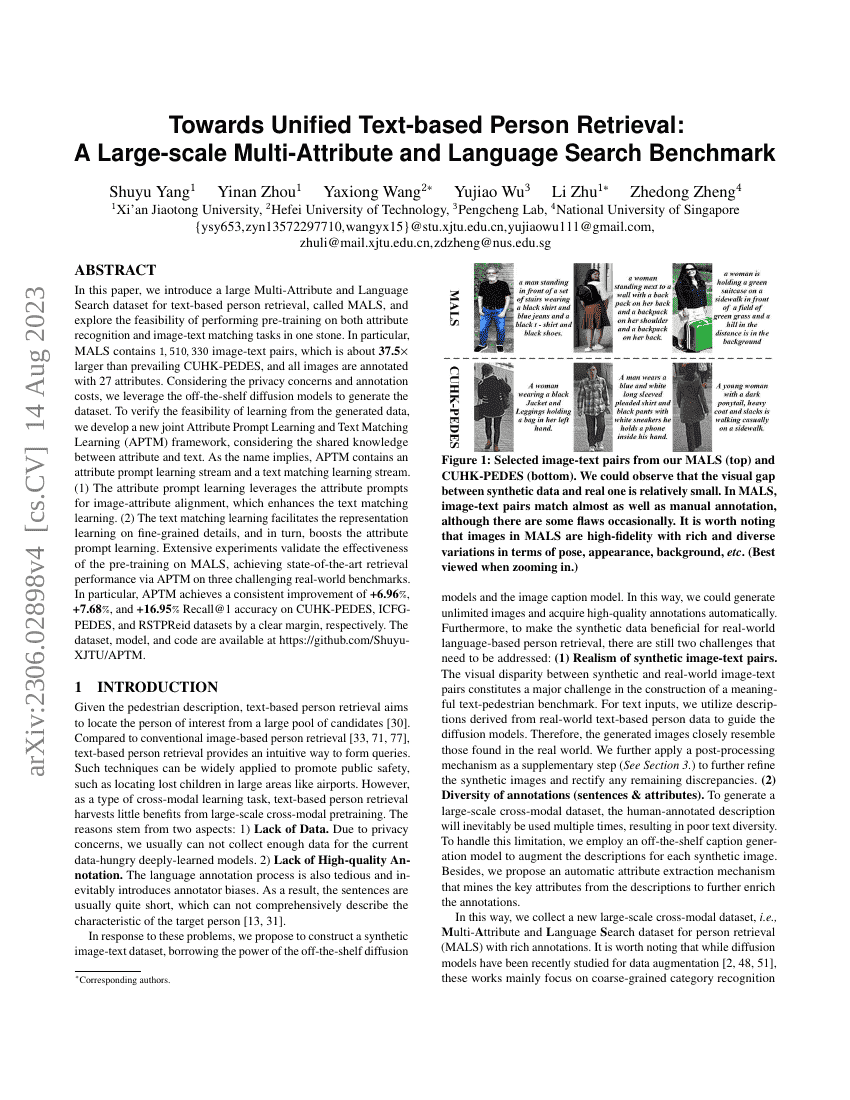

本文介绍了一个用于基于文本的人脸检索的大规模多属性和语言搜索数据集,称为MALS,并探讨了在同一模型中同时进行属性识别和图像-文本匹配任务预训练的可行性。具体而言,MALS包含1,510,330个图像-文本对,其规模约为现有CUHK-PEDES数据集的37.5倍,所有图像均标注了27个属性。考虑到隐私问题和标注成本,我们利用现成的扩散模型生成了该数据集。为了验证从生成数据中学习的可行性,我们开发了一种新的联合属性提示学习和文本匹配学习(APTM)框架,考虑了属性和文本之间的共享知识。如其名称所示,APTM包含一个属性提示学习流和一个文本匹配学习流。(1)属性提示学习通过利用属性提示实现图像与属性的对齐,从而增强文本匹配学习。(2)文本匹配学习有助于细粒度细节的表示学习,并反过来促进属性提示学习。大量实验验证了在MALS上进行预训练的有效性,通过APTM在三个具有挑战性的现实世界基准测试中实现了最先进的检索性能。特别是,APTM在CUHK-PEDES、ICFG-PEDES和RSTPReid数据集上的Recall@1准确率分别提高了6.96%、7.68%和16.95%,且提升幅度显著。

代码仓库

Shuyu-XJTU/APTM

官方

pytorch

GitHub 中提及

基准测试

| 基准 | 方法 | 指标 |

|---|---|---|

| nlp-based-person-retrival-on-cuhk-pedes | APTM | R@1: 76.53 R@10: 94.15 R@5: 90.04 mAP: 66.91 |

| pedestrian-attribute-recognition-on-pa-100k | APTM | Accuracy: 80.17 |

| text-based-person-retrieval-on-icfg-pedes | APTM | R@1: 68.51 mAP: 41.22 |

| text-based-person-retrieval-on-rstpreid-1 | APTM | R@1: 67.50 R@10: 91.45 R@5: 85.70 |