Command Palette

Search for a command to run...

DiffThinker:面向生成式多模态推理的扩散模型

DiffThinker:面向生成式多模态推理的扩散模型

Zefeng He Xiaoye Qu Yafu Li Tong Zhu Siyuan Huang Yu Cheng

摘要

尽管近期多模态大语言模型(MLLMs)在多模态推理方面取得了显著进展,但其推理过程仍主要以文本为中心,导致在复杂、长时程、以视觉为核心的任务中表现欠佳。本文提出一种全新的生成式多模态推理范式,并引入DiffThinker——一种基于扩散模型的推理框架。在概念上,DiffThinker将多模态推理重构为原生的图像到图像生成任务,从而在以视觉为核心的推理任务中实现了更优的逻辑一致性与空间精度。我们对DiffThinker与传统MLLMs进行了系统性对比,首次深入探究了该范式内在特性,揭示出四大核心属性:高效性、可控性、原生并行性以及协作能力。在四个不同领域(序列规划、组合优化、约束满足与空间布局)的大量实验表明,DiffThinker显著优于当前领先的闭源模型,包括GPT-5(提升314.2%)和Gemini-3-Flash(提升111.6%),同时也大幅超越微调后的Qwen3-VL-32B基线模型(提升39.0%)。这些结果充分证明,生成式多模态推理是一种极具前景的视觉中心化推理新路径。

一句话总结

作者来自包括 1、2、3 和 4 在内的多个机构,提出 DiffThinker,一种基于扩散模型的生成式多模态推理框架,将多模态推理重新定义为原生的图像到图像任务,通过利用原生并行性和可控性,在视觉主导的长时程问题中实现了更优的逻辑一致性和空间精度,超越 GPT-5、Gemini-3-Flash 和 Qwen3-VL-32B 在多个领域中的表现。

主要贡献

-

本文提出 DiffThinker,一种新颖的生成式多模态推理范式,通过扩散模型将多模态推理重新定义为原生的图像到图像生成任务,解决了视觉主导、长时程任务中以文本为中心推理的局限性。

-

通过在四个领域——顺序规划、组合优化、约束满足和空间配置——进行系统性评估,DiffThinker 展现出卓越性能,超越了包括 GPT-5(+314.2%)和 Gemini-3-Flash(+111.6%)在内的最先进模型,同时揭示了四个关键特性:高效性、可控性、原生并行性以及与 MLLMs 的协作潜力。

-

该框架通过在视觉空间中直接操作,实现了高逻辑一致性和空间精度;其扩展至视频生成(DiffThinker-Video)进一步验证了其有效性,表明生成式多模态推理是复杂视觉主导推理任务的有前景方向。

引言

作者针对当前多模态大语言模型(MLLMs)的局限性展开研究,这些模型依赖于通过冗长的思维链(Chain-of-Thought)过程进行以文本为中心的推理,以及迭代式的“带图像思考”交互。这些方法存在高延迟、生成长度不可控,以及在长推理序列中难以追踪视觉状态等关键瓶颈,这在空间配置和组合优化等复杂视觉主导任务中尤为突出。为克服这些挑战,作者提出 DiffThinker,一种基于扩散模型的框架,将多模态推理重新定义为原生的图像到图像生成任务,使推理从符号空间转向视觉空间。该范式实现了更优的空间精度和逻辑一致性,同时揭示了四大优势:高效性、可控性、探索多条解题路径的原生并行性,以及与 MLLMs 的协作潜力。在四个领域的广泛评估表明,DiffThinker 在性能上超越了 GPT-5 和 Gemini-3-Flash 等领先模型,最高提升达 314.2%,确立了生成式多模态推理作为视觉驱动问题求解的强大替代方案。

数据集

- 数据集由从 COCO(Lin 等,2014)合成的样本构成,用于五个拼图任务类别的训练与测试。

- 训练了五个独立模型,每个模型针对五个任务类别之一,评估在对应测试基准上进行。

- 所有训练数据均经过彻底去重,以确保数据质量并防止过拟合。

- DiffThinker 与基线 MLLMs 在相同的数据分布上进行训练,以实现公平比较。

- 训练集直接来源于 COCO,未使用任何外部数据源。

- 未描述显式的裁剪或元数据构建;重点在于使用原始 COCO 图像进行拼图合成。

- 五个任务类别的混合比例未明确说明,但每个模型均在与其类别对齐的数据上进行训练。

方法

作者利用基于扩散的框架实现 DiffThinker,一种专为复杂推理任务设计的生成式多模态推理器。核心架构基于多模态扩散 Transformer(MMDiT),在变分自编码器(VAE)的潜在空间中运行,以确保计算效率。该框架建立在流匹配(Flow Matching)理论之上,将从噪声到数据的变换建模为由常微分方程(ODEs)控制的连续流。模型的训练过程包括使用 VAE 编码器 E 将真实图像 y 编码为潜在表示 x0。从标准正态分布中采样噪声潜在变量 x1,并在随机采样时间步 t 处通过线性插值生成中间潜在变量 xt。目标速度场 vt=x0−x1 表示从噪声到数据的期望流。MMDiT 被训练以预测该速度场,其目标函数定义为预测速度与目标速度之间的均方误差,条件为用户指令 S,并通过多模态大语言模型(MLLM)ϕ 推导出条件潜在变量 h。

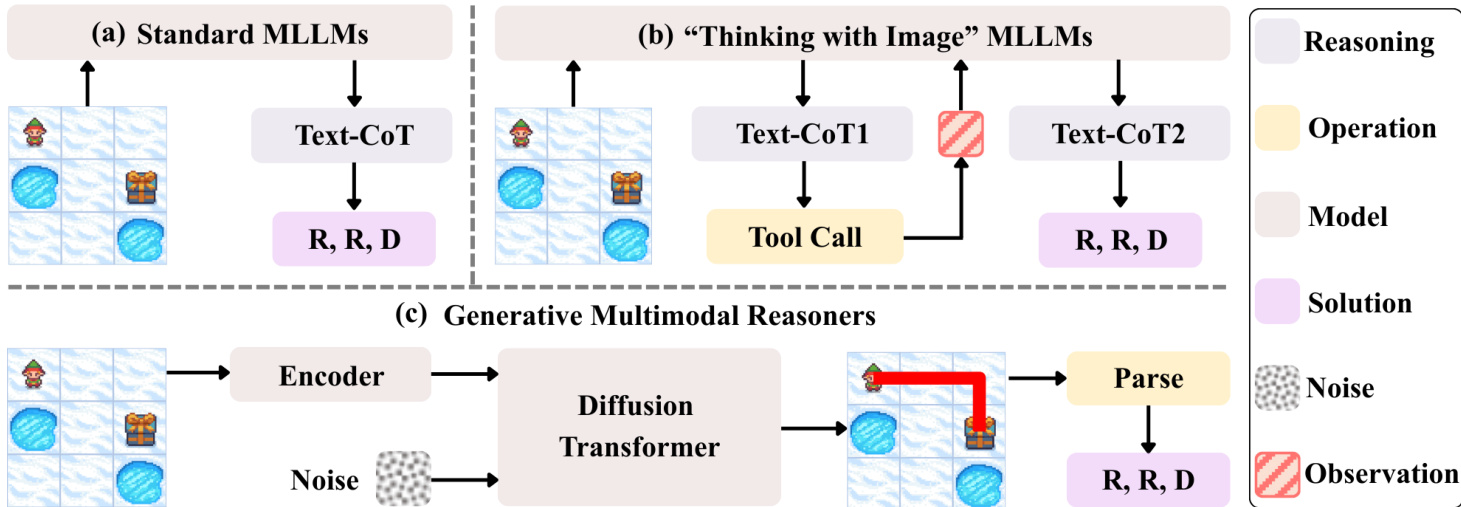

如图所示,DiffThinker 的整体框架由三个主要组件构成。第一部分(a)代表标准多模态大语言模型(MLLMs),它们处理输入图像和文本以生成推理轨迹,随后通过基于文本的思维链(Text-CoT)生成解决方案。第二部分(b)展示了“带图像思考”的 MLLMs,通过工具调用机制将视觉观察融入推理过程,生成中间推理步骤(Text-CoT1、Text-CoT2),最终输出解决方案。第三部分(c)详细描述了生成式多模态推理器,其中输入图像被编码并与噪声结合,经扩散 Transformer 处理后解析生成最终解决方案。该架构使模型能够通过在潜在空间中迭代优化理解与解题方案,来应对复杂任务。

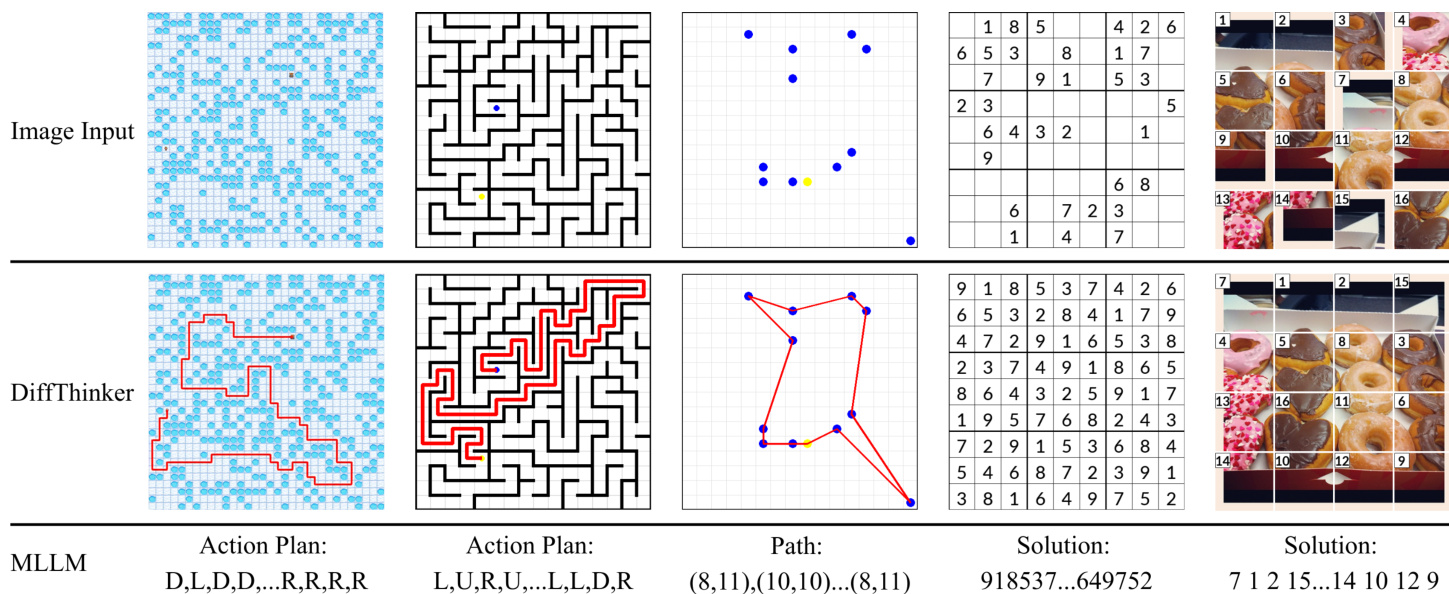

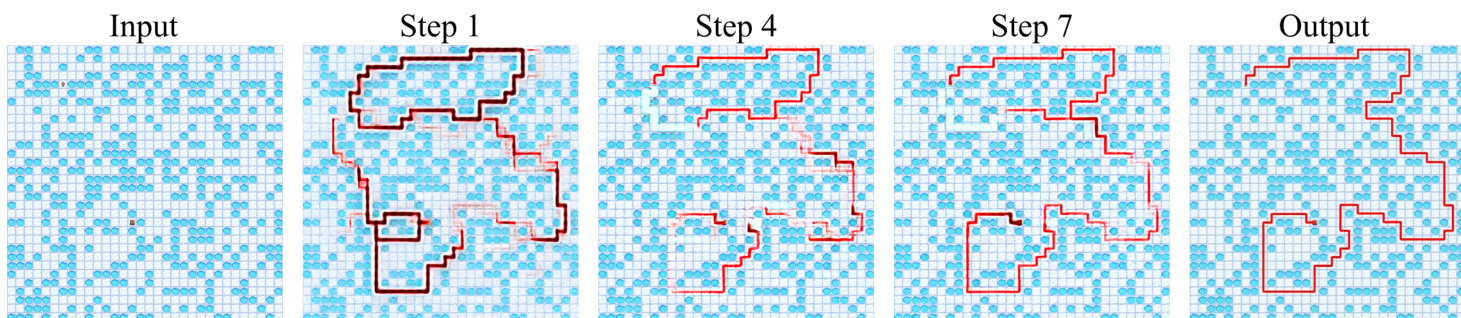

在推理阶段,模型从初始噪声潜在变量 xt=0=x1 开始,使用 ODE 求解器对学习到的速度场 vθ(xt,t,h) 进行数值积分。采用步长为 Δt=1/T 的一阶欧拉方法,更新规则为 xt+Δt=xt+Δt⋅vθ(xt,t,h)。经过 T 次积分步骤后,最终潜在变量 xt=1(近似数据分布)通过 VAE 解码器还原至像素空间,生成视觉解决方案 ysol。该过程使 DiffThinker 能够为一系列任务(包括顺序规划、组合优化、约束满足和空间配置)生成连贯且上下文相关的解决方案,如所提供示例所示。

为促进训练,作者为每个领域设计了特定的局部奖励函数,以应对二元奖励稀疏的问题。对于顺序规划任务,前缀匹配奖励评估正确动作的最长连续序列。对于旅行商问题(TSP),奖励分层设计,首先要求城市集合正确,再奖励路径长度精度。在数独任务中,奖励基于完成网格中正确填充单元格的比例。对于拼图任务,奖励衡量恢复图像块的位置准确性。这些奖励函数旨在为策略优化过程提供更具信息量的反馈,使模型能够有效学习复杂的推理模式。

实验

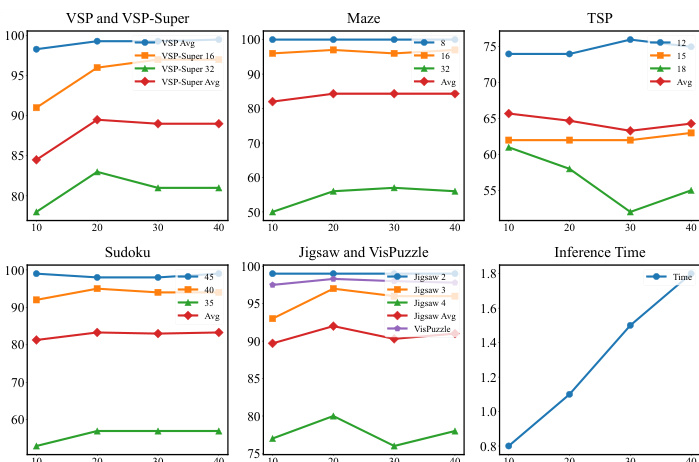

- DiffThinker 在七个任务上验证其生成式多模态推理范式:VSP、VSP-Super、Maze、TSP、Sudoku、Jigsaw 和 VisPuzzle,展示了在视觉主导、长时程推理中的卓越性能。

- 在所有任务上,DiffThinker 均达到最先进水平,超越 GPT-5(+314.2%)、Gemini-3-Flash(+111.6%)和微调后的 Qwen3-VL-32B(+39.0%),且参数量更少。

- 在顺序规划(VSP、VSP-Super、Maze)中,DiffThinker 在复杂度增加时仍保持高准确率,而 MLLMs 显著退化。

- 在空间配置(Jigsaw、VisPuzzle)中,DiffThinker 达到接近完美的性能;在组合优化(TSP)和约束满足(Sudoku)中,表现极为出色。

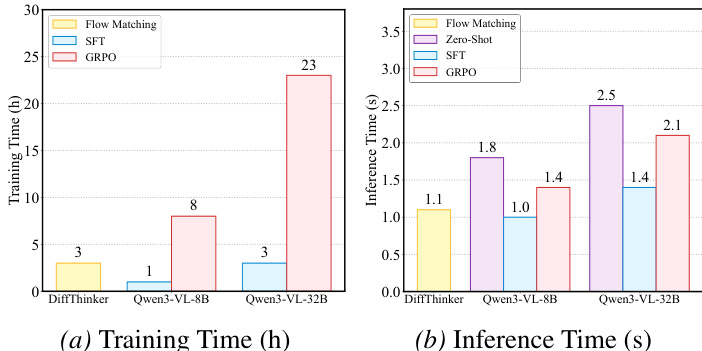

- DiffThinker 展现出具有竞争力的计算效率:训练时长与 Qwen3-VL-32B(SFT)相当,推理延迟为 1.1 秒,快于 Qwen3-VL-32B(1.4 秒),与 Qwen3-VL-8B(1.0 秒)相当。

- 通过固定步数扩散,模型实现可控推理,确保确定性延迟,与 MLLMs 不可预测的自回归推理形成对比。

- DiffThinker 实现原生并行推理,可同时探索多个候选路径并迭代优化,从而提升逻辑一致性和空间精度。

- 与 MLLMs 的协作框架在 Jigsaw level-4 任务中提升准确率,其中 DiffThinker 生成候选解,MLLMs 进行验证,充分发挥互补优势。

- 消融实验确认在 20 次推理步骤时性能最优,超过该点后准确率趋于平稳;性能随训练数据规模稳定提升,在 10⁵ 样本下于 Maze level-32 达到 90% 以上准确率。

- 无分类器引导(CFG)尺度为 4 时达到峰值性能,平衡了逻辑精度与生成保真度。

- 基于视频的推理(DiffThinker-Video)准确率较低且延迟更高(2.0 秒 vs. 1.1 秒),凸显当前视频生成在推理任务中的计算低效性。

作者使用 DiffThinker(一种基于扩散的模型)与 Qwen3-VL-8B 和 Qwen3-VL-32B 模型在不同训练方法下进行训练和推理时间对比。结果显示,DiffThinker 实现了具有竞争力的训练效率,训练时间为 3 小时,与 Qwen3-VL-8B(1 小时)相当,显著低于 Qwen3-VL-32B(23 小时)。DiffThinker 的推理时间为 1.1 秒,快于 Qwen3-VL-32B(2.1 秒),与 Qwen3-VL-8B(1.0 秒)相当,表明其在训练和推理阶段均具备高效性。

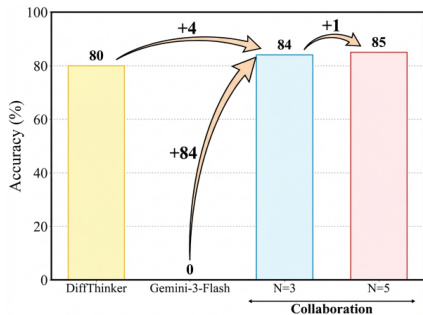

作者使用 DiffThinker 在与 MLLMs 的协作框架中评估其性能,其中 DiffThinker 生成多个候选解,MLLMs 负责验证。结果表明,协作显著提升了准确率,DiffThinker 单独达到 80% 准确率,结合五个候选解后提升至 85%,证明该协作模式优于任一模型单独使用。

结果表明,DiffThinker 在七个任务上均达到最先进水平,显著超越 GPT-5、Gemini-3-Flash 和微调后的 Qwen3-VL 模型,尤其在复杂、长时程、视觉主导的推理任务中表现突出。随着任务难度增加,模型保持高准确率,相比传统 MLLMs 展现出更优的逻辑一致性和空间精度。

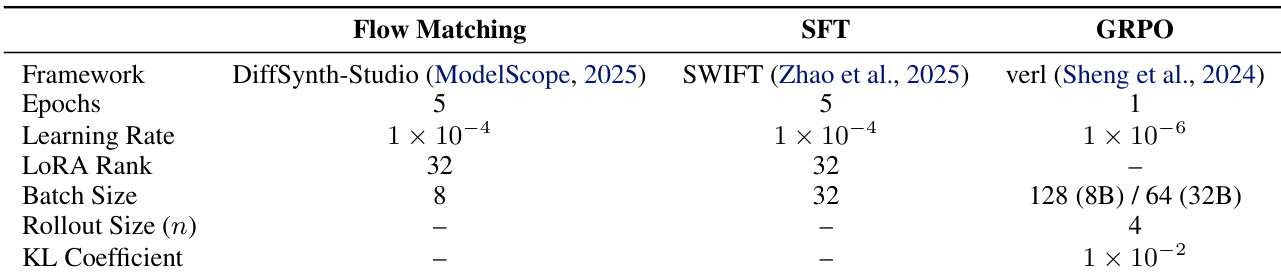

作者使用 DiffThinker(一种基于扩散的模型)将多模态推理任务重新定义为图像到图像生成问题。表格对比了三种不同框架——DiffSynth-Studio(流匹配)、SWIFT(SFT)和 verl(GRPO)——的训练配置,突出了学习率、LoRA 秩和批量大小等超参数的差异。结果显示,DiffThinker 在七个任务上均达到最先进水平,超越 GPT-5 和 Gemini-3-Flash 等模型,同时保持了具有竞争力的训练效率和推理延迟。

作者使用 DiffThinker(一种生成式多模态推理模型)解决一系列视觉主导任务,包括空间规划、组合优化和约束满足。结果表明,DiffThinker 在七个任务上均达到最先进水平,显著超越闭源与开源 MLLMs,平均准确率达 87.4%,远超 Gemini-3-Flash 的 41.3% 和 GPT-5 的 21.1%。