Command Palette

Search for a command to run...

DreamDojo:基于大规模人类视频的通用机器人世界模型

DreamDojo:基于大规模人类视频的通用机器人世界模型

摘要

能够模拟在多样化环境中执行动作的结果,将从根本上推动通用智能体的大规模发展。然而,由于数据覆盖范围有限以及动作标签稀缺,建模这些世界动态,尤其是在灵巧机器人任务中,仍面临巨大挑战。为此,我们提出了 DreamDojo——一个基础性世界模型,该模型通过学习44,000小时的第一人称人类视频,掌握了丰富的交互行为与灵巧控制能力。我们的数据混合集是迄今用于世界模型预训练的最大视频数据集,涵盖了广泛日常场景,包含多样化的物体与技能。为应对动作标签稀缺的问题,我们引入了连续隐变量动作作为统一的代理动作,显著提升了从无标签视频中迁移交互知识的能力。在小规模目标机器人数据上进行微调后,DreamDojo展现出对物理规律的深刻理解以及精确的动作可控性。此外,我们设计了一种知识蒸馏流程,使 DreamDojo 的推理速度提升至实时水平(10.81 FPS),并进一步增强了上下文一致性。本研究推动了基于生成式世界模型的多项重要应用,包括实时远程操控、策略评估与基于模型的规划。在多个具有挑战性的分布外(OOD)基准上的系统性评估验证了该方法在模拟开放世界、接触密集型任务中的显著优势,为通用机器人世界模型的发展铺平了道路。

一句话总结

来自 NVIDIA、香港科技大学、加州大学伯克利分校等机构的研究人员提出了 DREAMDoJO,这是一种基于 44,000 小时第一人称视频训练的基础世界模型,通过引入潜在动作克服动作标签稀缺问题,支持实时、物理感知的机器人仿真,适用于开放世界任务中的遥操作与规划。

主要贡献

- DREAMDoJO 是一种基于 44,000 小时第一人称人类视频预训练的基础世界模型,是目前该任务规模最大的数据集,能够通过利用人类与机器人交互中一致的物理规律,实现对未见过物体和环境的零样本泛化。

- 为克服动作标签稀缺问题,它引入连续潜在动作为统一的代理动作,允许从未标记视频中自监督学习细粒度可控性与物理规律,经过少量后训练即可显著提升对灵巧机器人任务的迁移能力。

- 一种新颖的蒸馏流程将模型加速至 640×480 分辨率下 10.81 FPS,同时增强长时序一致性,支持遥操作和基于模型的规划等实时应用,已在具有挑战性的分布外基准测试中得到验证。

引言

作者利用大规模人类视频数据训练 DREAMDoJO,这是一种能够在开放且未见过的环境中模拟灵巧机器人任务的基础世界模型。以往的视频世界模型在高维机器人动作和有限、仅限专家的数据集上表现不佳,限制了泛化能力和反事实推理能力。为克服稀疏的动作标签,他们引入连续潜在动作为统一代理,从而从 44,000 小时的第一人称人类视频中实现可扩展的自监督物理与可控性学习——这是目前同类数据集规模最大的。他们的蒸馏流程将推理速度加速至 10.81 FPS,同时保持视觉质量和长时序一致性,解锁了遥操作和基于模型的规划等实时应用。

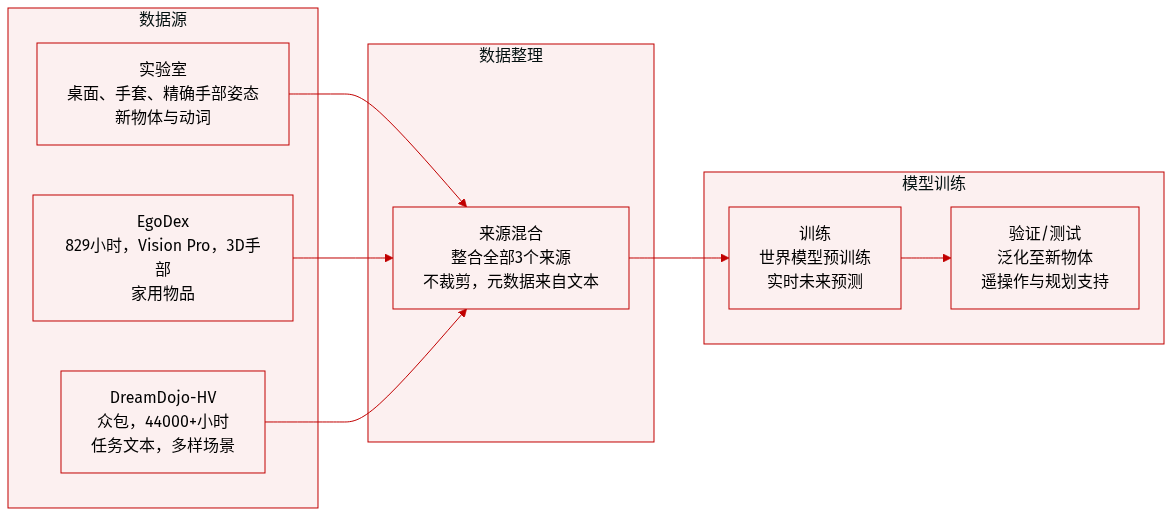

数据集

-

作者使用 DreamDojo-HV,一个包含 44,711 小时第一人称视频的数据集,用于预训练一个能够跨物体、任务和环境泛化的世界模型。这是目前用于该目的的最大人类交互数据集。

-

该数据集结合了三个来源:

- 实验室数据:使用 Manus 手套和 Vive 追踪器采集的桌面交互,实现精确手部姿态捕捉;支持直接重定向至 GR-1 机器人动作,包含新颖物体与动词。

- EgoDex:来自 Apple Vision Pro 的 829 小时公开第一人称视频,包含 3D 手/手指追踪和多样化的家庭物体,扩展物体种类。

- DreamDojo-HV(内部):众包视频,涵盖家庭、工业、零售、教育和行政场景中的移动-操作技能;每个片段包含任务文本标注。

-

完整数据集包含 9,869 个独特场景、6,015 个独特任务和 43,237 个独特物体——比以往世界模型数据集长 15 倍、技能多 96 倍、场景多 2,000 倍。

-

训练时,作者混合这些子集,未明确提及具体比例,但强调规模和多样性驱动性能提升。未描述裁剪策略;元数据基于每片段的任务文本标注以及场景/任务/物体标识符构建。

-

该数据集支持连续动作下的实时未来预测,支持遥操作,并允许无需真实世界部署的在线基于模型规划。

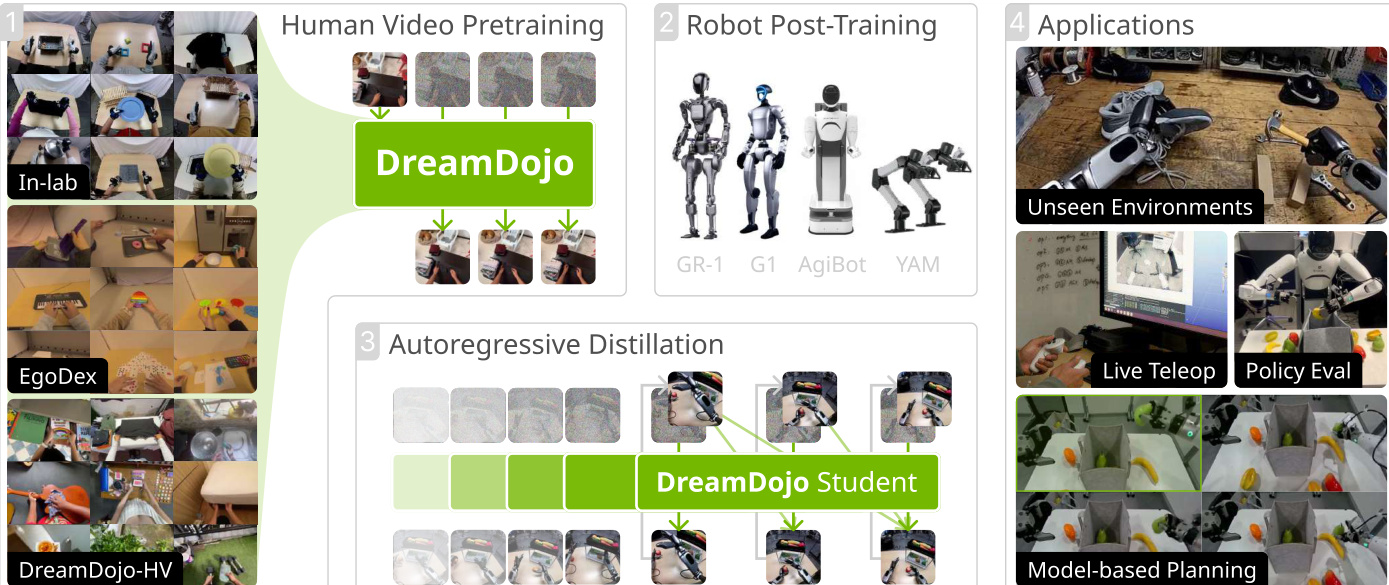

方法

作者采用三阶段训练流程构建 DREAMDoJO,这是一种能够从人类视频数据模拟机器人交互并适应目标本体的世界模型。整体框架始于在多样化第一人称人类数据集上的预训练,接着在机器人特定数据上进行后训练,最后通过蒸馏阶段实现实时自回归生成。请参阅框架图以了解此流程的高层概览。

架构核心是 Cosmos-Predict2.5 模型,这是一种在 WAN2.2 分词器生成的连续潜在空间中运行的潜在视频扩散模型。模型通过交叉注意力和自适应层归一化对文本、帧和动作进行条件化,使用流匹配损失进行训练。为增强动作可控性——这对机器人应用至关重要——作者引入两项关键架构修改。首先,他们将绝对机器人关节姿态转换为相对动作,通过将每帧潜在输入重新基准化为每 4 个时间步的起始姿态,从而降低建模复杂度并提升泛化能力。其次,为尊重因果性,他们以 4 个连续动作块的形式将动作注入潜在帧,而非作为全局条件,从而消除未来动作泄露并提高学习效率。

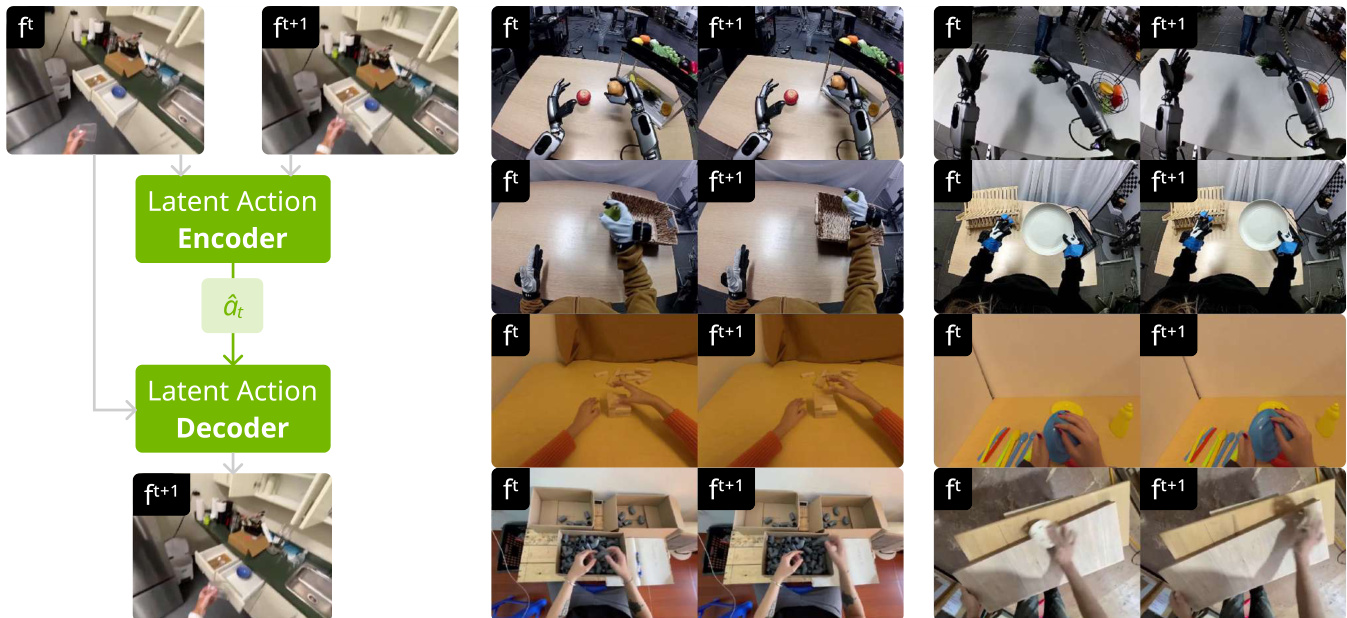

为支持在未标记人类视频上的预训练,作者引入基于时空 Transformer VAE 的潜在动作模型。该模型从连续视频帧 ft:t+1 中提取紧凑、解耦的动作表示,生成潜在动作 a^t,解码器结合 ft 用于重建 ft+1。训练目标结合重建损失和 KL 正则化以强制信息瓶颈,确保潜在表示仅编码最关键的动作。如下图所示,该潜在动作模型成功捕捉人类动作并支持跨本体泛化,允许在不同机器人平台上使用相同的动作表示。

预训练期间,作者对每个潜在帧以轻量级 MLP 投影的分块潜在动作进行条件化,MLP 初始化权重为零以保留预训练的物理知识。他们进一步通过在标准流匹配损失中增加时间一致性损失来增强时间连贯性,该损失惩罚连续潜在帧间速度差异:

Ltemporal(θ)=E[i=1∑K−1(zi+1−zi)−(vi+1−vi))2].最终训练目标是流匹配损失和时间一致性损失的加权和:

Lfinal(θ)=Lflow(θ)+λLtemporal(θ),实践中 λ=0.1。

针对目标机器人的后训练阶段,作者重新初始化动作 MLP 的第一层以匹配机器人的动作空间,并对整个模型进行微调。此阶段允许使用有限的机器人数据适应特定本体——如 GR-1、G1、AgiBot 和 YAM——同时保留预训练的泛化优势。

最后,为支持实时应用如实时遥操作和基于模型的规划,作者将基础模型蒸馏为自回归学生模型。这包括将双向注意力替换为因果注意力,并将去噪步骤从 50 步减少到 4 步。蒸馏分为两个阶段:预热阶段学生回归至教师生成的 ODE 轨迹,蒸馏阶段学生自回归生成并由基于 KL 的分布匹配损失监督。为缓解累积误差,学生被训练生成比教师更长的轨迹,监督通过随机采样的窗口应用。

实验

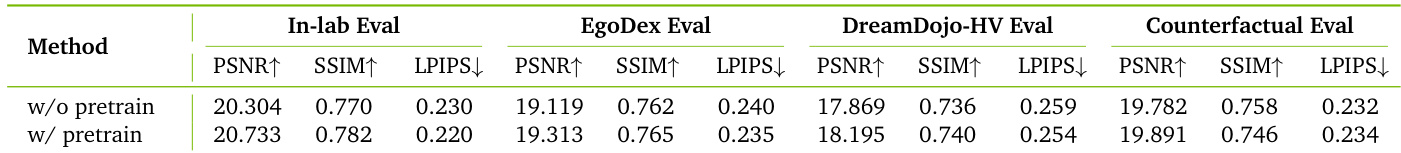

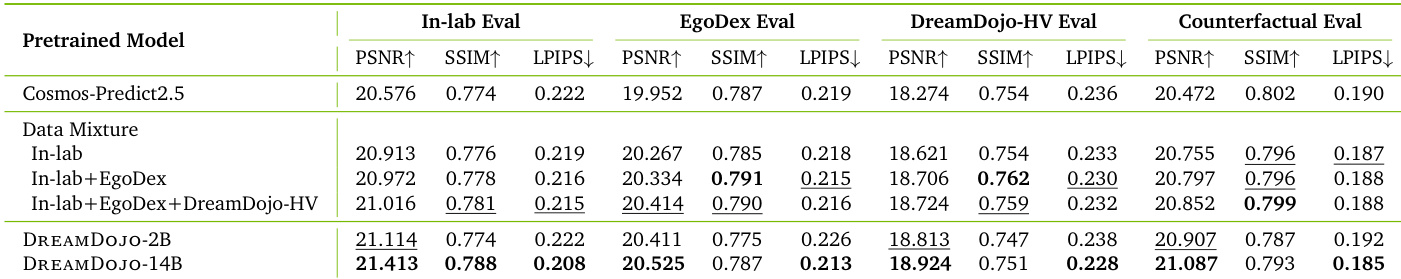

- 潜在动作条件化相比无动作预训练显著提升从人类视频的迁移能力,几乎匹配理想的真实动作设置。

- 预训练期间整合多样化人类数据集提升对新颖物理交互和反事实动作的泛化能力。

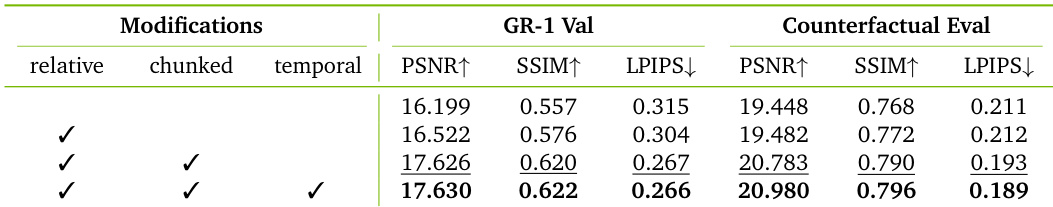

- 架构增强——包括相对动作、分块注入和时间一致性损失——显著提升仿真准确性和动作可控性。

- 蒸馏流程生成轻量级实时模型,在长时序轨迹中保持高保真度,同时提供更好的上下文感知和对遮挡的鲁棒性。

- DREAMDoJO 展示出强大的分布外泛化能力,尤其在编辑或新颖环境中,通过人类偏好评估验证。

- 下游应用表明 DREAMDoJO 可靠评估策略,支持有效的基于模型规划并带来显著性能提升,同时支持实时遥操作。

结果表明,在预训练期间整合更多样化的人类视频数据集在分布外场景和反事实动作中持续提升性能。DREAMDoJO-14B 变体在 SSIM 和 LPIPS 指标上表现最佳,表明生成视频在结构和感知保真度上更优。在预训练混合中加入 DreamDojo-HV 数据集进一步提升泛化能力,尤其在机器人训练数据中未见过的新交互上。

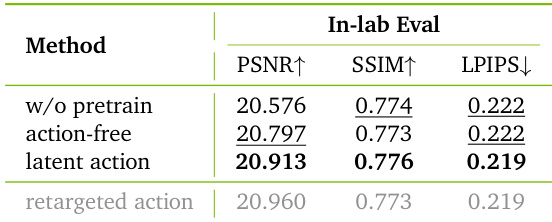

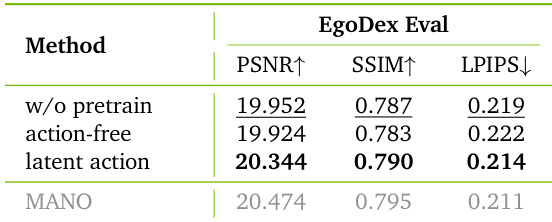

作者使用潜在动作条件化弥合无动作预训练与理想真实动作设置之间的性能差距,在仿真质量上接近重定向动作表现。结果表明,潜在动作显著提升从人类视频的迁移能力,同时保持可扩展性和实用性,无需专用动作捕捉硬件。

作者通过逐步应用相对动作、分块注入和时间一致性损失评估架构和损失设计选择。结果表明,每项修改均提升专家和反事实轨迹上的仿真质量,完整组合在所有指标上表现最佳。这证实精确的动作可控性和时间连贯性对准确的动力学预测至关重要。

作者使用潜在动作条件化弥合无动作预训练与理想真实动作设置之间的性能差距,在仿真质量上接近 MANO 基础条件化表现。结果表明,潜在动作显著提升从人类视频的迁移能力,同时保持可扩展性和实用性,无需专用动作捕捉硬件。

作者使用潜在动作条件化弥合人类视频预训练与机器人动作执行之间的差距,在仿真质量上接近需要精确动作捕捉的理想设置。结果表明,使用潜在动作预训练在多样化评估基准上显著提升仿真质量,相比无动作或无预训练,尤其在分布外场景中表现更优。该方法实现可扩展且有效的从人类交互知识向机器人系统的迁移,无需依赖专用硬件进行动作标注。